Was ist Generative AI? » Einführung in generative KI

1. Was ist Generative AI? Ein erster Überblick

Generative AI besteht im Kern aus Algorithmen, die aus vorhandenen Daten neue, originelle Inhalte erschaffen können. Beispiele, auf die du sicherlich schon gestoßen bist, sind Text-to-Text KIs ("LLMs"), wie ChatGPT oder Text-to-Image KIs wie Midjourney oder Stable Diffusion.

Definition von Generative AI

Generative AI (kurz GenAI) beschreibt Deep-Learning-Modelle, die hochqualitative Inhalte wie Text, Bilder, Videos, Musik oder Stimmen generieren können.

Der Output hängt von den Daten ab, mit denen die Modelle trainiert wurden. Generative KI kann z.B. aus Textdaten, Programmcode, Bilddateien oder Stimmaufnahmen lernen.

Aktuelle Generative AI Tools

Unter dem Begriff der generativen KI kannst du dir am besten etwas vorstellen, wenn du diese bereits einmal verwendet hast. Vielleicht sagen dir manche der folgenden Tools ja schon etwas.

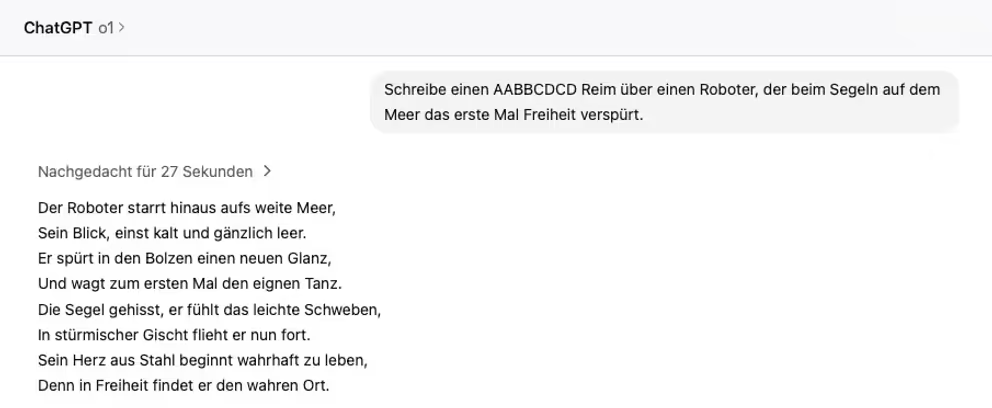

Generative AI-Tools für Text

Generative AI-Tools für Bildgenerierung

Generative AI-Tools für Sprach- & Audiogenerierung

Generative AI-Tools für Videogeneration

Generative AI als Teil des KI-Ökosystems

Generative AI ist ein Teil des großen Gebietes der Künstlichen Intelligenz. Lass uns einen Blick darauf werfen, welche anderen KI-Arten es gibt und wie sich GenAI von ihnen unterscheidet.

Anders als klassische KI-Systeme, die hauptsächlich auf Analyse und Klassifikation von Daten ausgelegt sind, liegt die Stärke der Generativen KI in der Erstellung neuer Inhalte.

Einordnung der Generativen KI

| KI-Art | Hauptfunktion | Beispielanwendungen |

|---|---|---|

| Generative KI | Erschafft neue Inhalte | Text-, Bild- oder Video-Generierung |

| Analytische KI | Analysiert Daten | Medizinische Diagnosen, Prognosen |

| Klassifikations-KI | Ordnet Daten ein | Spam-Filter, Bilderkennung |

| Robotik-KI | Steuert physische Systeme | Robotersteuerung, Autonomes Fahren |

2. Arten von Generative AI und ihre Anwendungsbereiche

Wie du weiter oben anhand der Kategorisierung der GenAI Tools vielleicht bereits erahnt hast, gibt es verschiedene Modelle für die unterschiedlichen Anwendungsbereiche.

Text- und Sprachgeneration

- Text-to-Text: Generiert Texte, wie Gedichte, Geschichten oder Lerninhalte, durch Aufforderung in Text-Form.

- Text-to-Speech: Generiert eine künstliche Sprachausgabe oder ganze Lieder anhand eines Text-Prompts.

- Speech-to-Text: Transkribiert aufgenommene Sprache automatisch in Text-Form und kann parallel noch inhaltliche Optimierungen oder Formatierungen vornehmen.

- Speech-to-Speech: Ändert die Stimmfarbe, entfernt Akzente oder Dialekte oder übersetzt Sprache in andere Sprachen.

Die Text- und Sprachgeneration hat sich in den letzten Jahren rasant entwickelt. Neben immer besser werdenden Lage-Language-Modellen (LLMs) wie GPT, Claude oder Gemini, hat sich auch generative KI für die Audio-Sprachausgabe stark verbessert.

Neue Modelle weisen eine immer niedrigere Latenz bei der Generierung auf, was dazu führt, dass sich heute ganz anders mit Sprachmodellen arbeiten lässt, als noch zu Zeiten von Alexa oder Siri.

Inzwischen ist es keine Science Fiction mehr, dass man über natürliche Sprache einen Computer steuern und diesem Fragen stellen kann.

Anwendungsbeispiele für Text- und Sprach-KIs

- Schreibassistenten (Journalisten, Autoren, Content Creators)

- Programmierung (Coding-Agenten, Auto-Vervollständigung, Testing etc.)

- Komponieren (Demotapes, Arrangements, Sound-Effekte etc.)

- Transkribieren (Interviews, Meeting-Notizen etc.)

- Wissenschaftliche Forschung (Research-Zusammenfassungen, Datenverarbeitung etc.)

Bild- und Videogeneration

- Text-to-Image: Generiert Bilder anhand von Textbeschreibungen.

- Image-to-Image: Transformiert bestehende Bilder in andere Stile oder entfernt / baut neue Elemente ein.

- Image-to-Text: Beschreibt Bildinhalte in Textform, z.B. für Bildunterschriften

- Text-to-Video: Erstellt (kurze) Videos anhand von Skripten oder Textvorgaben

- Text-to-3D: Erstellt einfache 3D-Modelle anhand von Textbeschreibungen

- Image-to-3D: Rekonstruiert 3D-Geometrie anhand von 2D-Bildmaterial

Moderne Bildgenerierungs-KIs können innerhalb weniger Sekunden Kunstwerke schaffen, für die es vor wenigen Jahren noch Stunden an fähiger Arbeit benötigt hätte. Bild-KIs wie Midjourney, DALL-E oder Flux (aus dem Schwarzwald), werden immer besser, indem sie anfängliche Probleme bei der Darstellung von Händen und Fingern oder die Konsistenz von Charakteren (Identity Consistency Problem) stetig verbessern.

Mit Runway und Sora wurden in der Zwischenzeit die ersten Video-Modelle entwickelt, mit denen kurze, zusammenhängende Videosequenzen durch Text-Prompts generiert werden können. Da Videogenerations-AIs hohe Ressourcen an Rechenleistung benötigen, ist davon auszugehen, dass in der Zukunft noch großer Spielraum für bessere Modelle vorhanden ist.

Viel Potential steckt auch in generativen Modellen, die anhand von Text oder Bildern 3D-Modelle erstellen können. Diese Modelle können vor allem für Gaming und Unterhaltungsfilme, aber auch für Architekten oder im E-Commerce produktiv verwendet werden.

Anwendungsbeispiele für Bild- und Video-KIs

- Kunst & Kultur (Kreative Kunstwerke, Rekonstruktion in der Archäologie, Analyse von Maltechniken etc.)

- Game-Design (Texturen, 3D-Modelle, Landschaften etc.)

- Unterhaltungsbranche (Spielfilmsequenzen, Spezialeffekte etc.)

- Architektur (Explorationen, Beschleunigung von Prozessen)

- E-Commerce (Aufbereitung von Produktvisualisierungen, Werbung etc.)

3. Technische Grundlagen von Generative AI

Du hast nun hoffentlich einen guten Überblick über die verschiedenen Arten von Generativer KI und ihren Anwendungsbereichen. Vielleicht hast du dir auch bereits die Frage gestellt, wie diese Modelle dazu in der Lage sind, Outputs zu generieren, die teilweise nicht von menschengemachten Inhalten zu unterscheiden sind.

Im folgenden Abschnitt schauen wir uns die technischen Grundlagen von Generative AI einmal genauer an.

Techniken und Architektur generativer KI-Modelle

Generative AI-Modelle sind Systeme, die über maschinelles Lernen trainiert werden. Das bedeutet, dass riesige Datenmengen Algorithmen durchlaufen, anhand derer die Modelle Zusammenhänge zwischen den Daten herstellen, also "lernen" können.

Viele Generative AI-Modelle werden über Unsupervised Learning trainiert. Das bedeutet, dass die Modelle mit rohen, unstrukturierten Daten trainiert werden. Der Vorteil dieser Lernmethode ist, dass zuvor keine Resourcen benötigt werden, über die die Daten gelabelt und in ein strukturiertes Format gebracht werden müssen, wie es bspw. beim Überwachten Lernen der Fall ist.

Generative AI Frameworks

- Transformer: Basis moderner Sprachmodelle mit Attention-Mechanismen

- General Adversarial Networks (GANs): Zwei Neuronale Netzwerke, die sich gegenseitig trainieren

- Diffusion: Schrittweise Verfeinerung des Outputs durch Reduzierung von Noise

- Variational Autoencoder: Generatives Modell, das eine latente Verteilung lernt und so in der Lage ist, Variationen komplexer Daten (z.B. Bilder) realistisch zu erzeugen

Transformer-basierte Modelle

Transformer-Modelle haben die Art und Weise, wie die Sprachverarbeitung über KI funktioniert, grundlegend verändert. Die Transformer-Architektur wurde 2017 im revolutionären Paper "Attention is All You Need" vorgestellt.

Das Herzstück der Transformer ist der "Attention"-Mechanismus. Stell dir vor, du liest einen komplexen Satz: Dein Gehirn achtet besonders auf die Wörter, die für das Verständnis wichtig sind, und weniger auf nebensächliche Begriffe. Genauso funktioniert der Attention-Mechanismus: Er gewichtet die Bedeutung verschiedener Input-Teile dynamisch.

Ein weiteres Schlüsselelement ist das "positional Encoding". Da Transformer-Modelle parallel arbeiten und nicht sequentiell wie frühere Modelle, müssen sie die Position jedes Wortes im Satz "kennen". Das positional Encoding fügt diese Information hinzu und ermöglicht es dem Modell, die Struktur von Sätzen zu verstehen.

Transformer bilden aktuell die Grundlage für die leistungsfähigsten KI-Modelle wie GPT-4, Claude und BERT. Transformer-basierte Modelle werden auch für die Bild- und Videoverarbeitung eingesetzt.

GAN-Modelle

Die Funktionsweise von GANs kannst du dir so vorstellen, dass zwei neuronale Netzwerke gegeneinander antreten. Es gibt einen Generator und einen Discriminator. Der Generator versucht Daten zu erzeugen, die möglichst nah an echte Daten herankommen. Der Discriminator versucht auf der anderen Seite herauszufinden, ob es sich um echte oder vom Generator gefälschte Daten handelt.

Dieser "Wettkampf" führt zu einer kontinuierlichen Verbesserung beider Netzwerke. Der Generator wird immer besser darin, realistische Daten zu erzeugen, während der Discriminator immer genauer in der Unterscheidung / Klassifizierung wird.

Mit GANs lassen sich insbesondere in der Bildgenerierung fotorealistische Gesichter erzeugen, Bilder in verschiedene Kunststile umwandeln oder sogar niedrig aufgelöste Bilder verbessern. Ein bekanntes Beispiel ist z.B. die Website ThisPersonDoesNotExist.com, auf der bei jedem Seitenaufruf ein täuschend echtes Gesicht generiert wird.

Diffusion Modelle

Diffusion-Modelle arbeiten nach einem völlig anderen Prinzip als GANs: Sie lernen, wie man schrittweise Noise in strukturierte Daten umwandelt.

Der Prozess ähnelt der umgekehrten Diffusion in der Physik. Stelle dir vor, du tropfst einen Tropfen Tinte in Wasser. Dann verteilt sich die Tinte zunächst gleichmäßig im Wasser (Diffusion). Diffusion-Modelle lernen den umgekehrten Prozess: aus dem gleichmäßig verteilten Zustand wieder ein strukturiertes Bild zu erzeugen.

Modelle wie Stable Diffusion und DALL-E 2 basieren auf dieser Technologie. Diffusion Modelle können heutzutage eine hohe Bildqualität erreichen und lassen sich über Parameter individuell steuern. Ein besonderer Vorteil ist ihre Stabilität im Training – sie sind deutlich zuverlässiger zu trainieren als GANs.

VAE-Modelle

VAEs verbinden Deep Learning mit probabilistischer Modellierung. Ein VAE besteht aus zwei Hauptkomponenten: einem Encoder und einem Decoder. Der Encoder wandelt Eingabedaten in eine probabilistische Repräsentation im latenten Raum um. Der Decoder nimmt dann Stichproben aus diesem latenten Raum und rekonstruiert daraus neue Daten.

Im Gegensatz zu Transformern arbeiten VAEs also mit probabilistischen Ansätzen anstatt mit Attention-Mechanismen. VAEs werden häufig in der Bild-, aber auch Audiogenerierung verwendet.

4. Chancen und Risiken von Generativer KI

Noch lässt sich das Potential und die Auswirkung, die Generative AI auf unser Leben haben wird, nur erahnen. Doch mit Chancen kommen auch Risiken einher. Die möglichen Vorteile und Nachteile von generativer KI haben wir in der folgenden Liste gesammelt:

Chancen durch Generative AI

- Massive Produktivitätssteigerungen durch Automatisierung und Optimierung von Arbeitsprozessen möglich

- Demokratisierung von Expertenwissen

- Personalisierte Bildung / individualisierte Lernmöglichkeiten für den Bildungssektor

- Überwindung von Sprachbarrieren durch Echtzeitübersetzungen

- Entstehung neuer Berufsfelder

Risiken von Generative AI

- Gefahr von Desinformationen und Manipulation durch KI-Bots auf Social Media oder Deep-Fakes

- Datenschutz- und Sicherheitsbedenken

- Rechtliche Ungewissheit bei Urheberrecht

- Gesellschaftliche Aufgabe, mögliche Jobverluste aufzufangen

- Potenzielle Verstärkung sozialer Ungleichheit

Generative künstliche Intelligenz erfährt aktuell ein exponentielles Wachstum und entwickelt sich rasant. Schon heute ist klar, dass die Technologie das Potential hat, unsere Gesellschaft nachhaltig zu verändern.

Im nächsten Abschnitt werfen wir abschließend noch einen Blick auf die Themen und Entwicklungen, die wir in den kommenden Jahren erwarten können.

5. Ein Blick in die Zukunft: Weiterentwicklung von Generativer KI

Wer die technischen Entwicklungen von KI-Systemen verfolgt, der weiß, wie schnell in den letzten Jahren neue Durchbrüche erzielt wurden.

Für das Jahr 2025 sehe ich hauptsächlich folgende Trends für Generative KI-Systeme:

KI-Agenten

Autonome KI-Systeme, die komplexe Aufgabenketten selbstständig ausführen

Lokale Modelle

Leistungsstarke KI direkt auf deinem Gerät

Multimodale Modelle

Integration von Text, Bild, Audio und Video in einem System

Video-KI

Fortschritte in der KI-gestützten Videogenerierung

KI-Agenten: Produktive & autonome KI-Systeme

Ich gehe davon aus, dass 2025 die ersten produktiven KI-Agenten veröffentlicht werden. Diese werden eigenständig Aufgabenketten abarbeiten können und ohne menschliches Eingreifen zu produktiven Ergebnissen gelangen.

Katalysator für diese Modelle werden u.a. Effizienzgewinne im Training sowie günstigere Tokenpreise sein.

Multimodale Modelle sind im Kommen

Die nächste Generation von KI-Modellen wird verschiedene Modalitäten nahtlos integrieren. Ein einzelnes Modell wird Text, Bilder, Audio und Video gleichzeitig verstehen und generieren können. Einen guten Prototyp hierfür hat Anthropic bereits mit "Computer Use" geliefert.

Lokale Modelle - Verbesserte Privatsphäre

Der Trend zu lokalen KI-Modellen wird sich immer mehr verstärken. Lokale Modelle sind kleiner und effizienter, können aber direkt auf deinem Gerät laufen – ohne Internetverbindung und mit maximaler Privatsphäre.

Inzwischen lassen sich auf neueren Smartphone-Modellen sogar bereits leistungsstarke Small-Language-Modelle wie Ministral-8B-Instruct, Qwen3 oder Llama-3.2-8B betreiben. Verwenden lassen sich diese Modelle über Apps wie z.B. Apollo AI.

Fortschritt in der Videogenerierung

Die Entwicklung im Bereich der Video-KI wird in diesem Jahr aller Voraussicht nach weiter stark vorangetrieben. Längere Sequenzen und besseres Verständnis von Physik durch leistungsfähigeres Training wird dazu führen, dass wir schon bald KI-generierte Video-Inhalte auf der Kino-Leinwand bewundern dürfen.